贅沢なエンタメだな〜〜。

バーチャルなYouTuber、VTuber。最近ではYouTube上だけでなく地上波で見る機会も増えてきましたね。VTuberと現実のタレントさんとのコラボなんかもよく見かけます。

そんなバーチャル×現実の次元超えコラボを、3D空間上でやってのけたイベント「バズリズム LIVE V 2023」が、2023年7月29日にニコニコ動画やSPWNにて有料ライブ配信されました。

これ、ただの映像の合成じゃありません。3D空間上に現実のバンドとVTuberが共存していて、カメラもグリグリ周りを動きながら撮影されているのです。

すべてのきっかけは、ここから

開催のきっかけは、お笑い芸人のバカリズムさんが司会を務める音楽番組「バズリズム02」に、VTuberの星街すいせいさんが出演したこと。今までやってきた現地でのライブとは違う、バーチャルなライブイベントとして(やんわりと)コラボが決まった次第です。

なので、出演アーティストはほとんどがVTuber。コチラでライブ冒頭を無料視聴できますが、後半の有料部分では、バカリズム×フジファブリック×星街すいせいのような、現実のアーティストとVTuberの同時共演も実現しました。

…と、言葉でいうのは簡単ですが。よーく考えると、これってすごいんですよ。バーチャル空間にいるVTuberと現実の人間、一体どうやってコラボしてるの? というか僕たちが見ている映像はバーチャル空間ですし、どうやってバーチャル空間に二次元と三次元のキャラクターを共存させたの?

実は、撮影現場に事前にお邪魔させてもらい、撮影の様子を取材してきました。何やら緑色の謎空間が見えますが、コレは一体…?

2つの撮影技法を合体

今回のライブ配信は、2つの撮影アプローチによって成立しています。

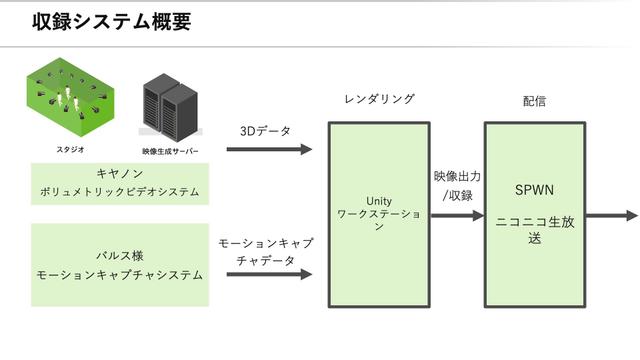

1つはキヤノンのボリュメトリックビデオ技術による3Dモデル撮影と、バーチャルなキャラクターを動かすモーションキャプチャー技術です。モーションキャプチャーは、AR・VR系コンテンツを手掛けているバルス株式会社が担当しています。

図にするとこんな感じ。キヤノン側はリアルなアーティストの撮影を担当し、バルス側はバーチャルなタレントの撮影を担当。

それぞれの出来上がったデータをUnityでレンダリングして、最終的にライブ配信にのせるというかたちです。

と、テキストだけで説明されても「???」って感じですよね。わかります。なので、現地行って見てきました。

自由な画角を生み出せる、ボリュメトリック

ボリュメトリックビデオ(Volumetric video)とは、複数のデジカメで撮影した映像を3D空間データとして再構成する技術のこと。3Dデータ化することで、映像の画角を撮影後に自由に移動させることができるんです。

キヤノンはボリュメトリック撮影を可能とする巨大なスタジオを持っており、冒頭の緑色の空間がそれです。「バズリズム LIVE V 2023」ではこのスタジオで現実の人物撮影を行い、3Dデータ化することでバーチャル世界の住人となれたわけですね。

ここがそのスタジオです。いざ、潜入。

柔道できるくらい広い! マイクやアンプ、キーボードが置いてありますね。演奏の後かな?

よく見ると壁には黒い穴が。欠陥工事かと思いきや…。

これ全部、キヤノンのカメラのレンズなんです。4K60fps撮影なカメラが100台以上も設置されているそうな。

壁だけでなく天井にもカメラが。あらゆる角度の映像を撮ることで、3Dデータ化した際に破綻が出ないようにしているのでしょう。

ちなみに、このボリュメトリックスタジオのすごいところは、撮影した映像は遅延3秒のほぼリアルタイムで3Dデータ化される点にあります。今年3月には同じ撮影システムが東京ドームにも導入され、様々な角度からシーンをリプレイできるようになりました。

撮影中や撮影後の映像は、コントローラーでカメラ位置を調整することができます。普通の動画は一度撮影した映像の画角を変える(寄ったり回り込んだりする)ことはできませんが、3Dデータならいくらでもカメラワークを変えられるわけですね。

にしてもこれ、4K60fpsの映像×100台以上のカメラのデータを瞬時に取り込んでるわけですから、恐ろしいデータ量ですよね…。しかもそのデータを3秒で見えるかたちにしてくれるんですから。恐るべし、ボリュメトリック。

モーションキャプチャーはこんな現場で行なわれていた

お次はバルス側の撮影環境、すなわちモーションキャプチャーの現場を見ていきましょう。

ボリュメトリックのスタジオよりもかなりコンパクトです。というか、ボリュメトリックの撮影とモーションキャプチャーの撮影、離れた場所で行なわれてるんですよね。離れた場所で撮影したのに最終的には同じバーチャル空間にいるのは、不思議な感じ。

スタジオを覆うフレームの上部には、モーションキャプチャーのマーカーを読み取るセンサーがありました。演者は体にマーカーを着けて動き回り、それをセンサーが読み取ることで、バーチャルのアバターを動かします。

意外だったのは、オペレーターがたくさん(8人程度?)いたこと。1人の演者に対して、その動きを確認するためのモニターやPCは10台以上ありました。演者の動き以外にもチェックする要素は多いみたいですね。

撮影中は、このカメラ(?)を持って演者の周囲を回り込んで撮影する人も。ジンバルにスマホが2台くっついてますが、1つはステージの引きを、もう1つは撮影者の視点を映しているようで、いわばバーチャル内でのカメラ撮影をしていたみたい。

3秒の遅延は、レンダリング時に巻き取る

キヤノン側ではアーティストのライブ演奏などを撮影し、バルス側ではVTuberなどバーチャルキャラクターの動きを撮影。それぞれのデータはワークステーションに集約され、Unityでレンダリングして最終的な映像として出力されます。

このときに留意すべき点が、ボリュメトリック側で撮影した映像は3秒の遅延があるということ。実際の撮影では音や声に合わせて動いているので、そのまま音と映像を書き出すと、モーキャプ側ともズレが生じます。

こうしたズレなども、レンダリング工程で解消させておくわけですね。カメラワークを調整したり、3Dデータ化された人物とVTuberが一緒に並んでも違和感が出ないようにしたり、色々な調整を経ることでアウトプットまで至ります。

XRコンテンツの現在地を見た気がする

現実とバーチャルを組み合わせた今回のライブは、いわばXRコンテンツです。その最先端現場が、こうしたスタジオなんだなぁと実感しました。想像以上に人も機材も大掛かりで、映画やドラマの撮影現場と遜色ない緊張感です。

と同時に、未来への期待も感じました。例えばボリュメトリックのシステムは、ビットレートやカメラの解像度が向上すれば、バーチャル内に描画する人物のディテールがもっと細かくなるはず。モーキャプの技術も日々進化していってますしね。

テクノロジーは進み続けるものと思えば、このあたりのエンタメの完成度って確実に上がっていくんだよなぁ。次元交差系エンタメの現在地、堪能させていただきました。

Source: バズリズム LIVE V 2023, SPWN, YouTube1, 2, 3